CérénIT

Le blog tech de Nicolas Steinmetz (Time Series, IoT, Web, Ops, Data)

InfluxDB 2.0 OSS - Notes de mise à jour

timeseries influxdb flux grafana telegrafInfluxDB 0SS 2.0 étant sortie, j’ai testé la mise à jour d’une instance 1.8.3 vers 2.0.1 sur une VM Debian 10 à jour.

Mise à jour

La documentation pour une mise à jour 1.x vers 2.x est disponible. La vidéo “Path to InfluxDB 2.0: Seamlessly Migrate 1.x Data” reprend cela et va plus loin en présentant bien tous les points à prendre en compte (y compris pour Telegraf, Chronograf et Kapacitor). Je ne rajouterai donc que mes remarques.

Concernant la commande influxd upgrade :

- Il est fort probable qu’il faille rajouter la commande

sudopour ne pas avoir de problèmes de permisisons. - Par défaut, les données migrées vont être mises dans

~/.influxdbV2. Or je doute que vous vouliez que vos données soient à cet endroit. Je vous invite donc à regarder la documentation deinfluxd upgradepour définir les propriétés--engine-pathet--bolt-path

Exemple:

mkdir -p /srv/influxdb/influxdb2

influxd upgrade --engine-path /srv/influxdb/influxdb2/engine --bolt-path /srv/influxdb/influxdb2/influxd.bolt

- A l’issue de la migration, un fichier

config.tomlest généré dans/etc/influxdb/. Il contient quelques valeurs issues de la migration et des valeurs par défaut. Je l’ai personnalisé de la façon suivante pour tenir compte de mes valeurs :

bolt-path = "/srv/influx/influxdb2/influxd.bolt"

engine-path = "/srv/influx/influxdb2/engine"

http-bind-address = "127.0.0.1:8086"

storage-series-id-set-cache-size = 100

- Post-migration, le service

influxdcherchait à initialiser ses fichiers dans/var/lib/influxdb/.influxdbv2. Ayant noté que le service InfluxDB prennait/etc/default/influxdbcomme fichier d’environnement, j’ai ajouté dans ce fichier :

# /etc/default/influxdb

INFLUXD_CONFIG_PATH=/etc/influxdb/config.toml

Dès lors, /etc/influxdb/config.toml était bien pris en compte et InfluxDB démarrait bien avec mes données.

Une fois InfluxDB 2 démarré, j’ai pu noter avec plaisir :

- que l’ingestion via telegraf continuait à se faire sans interruption,

- que mes dashboards Grafana continuaient à fonctionner.

Je n’ai donc pas d’urgence à migrer la configuration et le paramétrage de ces derniers. Je vais pouvoir le faire progressivement ces prochains jours.

N’utilisant pas Chronograf et Kapacitor, je n’ai pas eu de données à migrer ou d’ajustements à faire à ce niveau là. La vidéo reprend bien les points d’attention et les éventuelles limitations à prendre en compte dans le cadre de la migration.

Finalement, c’est pas mal qu’ils aient réintégrer les endpoints 1.x dans la version 2.0 à ce niveau là ;-)

La 2.0.2 étant sortie pendant ma mise à jour, j’ai poursuivi la mise à jour. Je suis tombé sur ce bug rendant l’écriture de données impossibles. Cela a mis en évidence un bug sur la migration des “retention policies” et sur le fait que j’avais aussi des très vieilles bases InfluxDB. Je n’aurai a priori pas eu ce bug en faisant la migration 1.8.3 vers 2.0.2. En tous cas, une 2.0.3 devrait donc arriver prochainement avec une amélioration du processus de migration faisant suite à ma séance de troubleshooting.

Migration des configurations

Elle peut se faire très progressivement - si par ex vous utilisez telegraf pour envoyer vos données et Grafana pour la partie dashboarding :

- Vous pouvez mettre à jour votre configuration telegraf en passant de l’outputs

influxdbà l’outputinfluxdb_v2sans impacter grafana qui continuera à accéder à vos données en InfluxQL - Vous pouvez ensuite mettre à jour votre datasource InfluxDB ou plutôt en créer une nouvelle et migrer vos dashboards progressivement sans interruption de service

Créer un accès en InfluxQL à un nouveau bucket

Si vous devez rétablir un accès à vos données via les API 1.x à un bucket nouvellement créé (j’ai profité de la migration pour mettre des buckets clients dans des organisations représentant les clients en question).

# Créer le bucket

influx bucket create --name <BUCKET_NAME> --retention 0 --org <ORGANISATION>

# Récupérer l'ID de bucket via la liste des buckets

influx bucket list

# Créer une DBRP (DataBase Retention Policies) pour le bucket en question - les accès en 1.x se font en mode SELECT * FROM <db_name>.<retention_policies> ...

influx v1 dbrp create --bucket-id=<BUCKET_ID> --db=<BUCKET_NAME> --rp=autogen --default=true

# Créer un utilsateur sans mot de passe pour le moment

influx v1 auth create --username <USER> --read-bucket <BUCKET_ID> --write-bucket <BUCKET_ID> --org <ORGANISATION> --no-password

# Créer un mot de passe au format V1

influx v1 auth set-password --username <USER>

Les utilisateurs migrés depuis la version 1.x sont visibles via influx v1 auth list.

Intégration InfluxDB 2.0 / Flux et Grafana

Le support de Flux dans Grafan existe depuis la version 7.1 mais il n’est pas aussi aisé que celui dans InfluxDB 2.0 OSS. Il y a certes de la complétion au niveau du code ou le support des variables mais pas de capacité d’introspection sur la partie données.

Pour le moment, je procède donc de la façon suivante :

- Création de la Requête via le Query Builder dans InfluxDB 0SS

- Passage en mode “Script editor” pour dynamiser les variables ou ajuster certains comportements

- Copier/coller dans l’éditeur de Grafana

- Ajustement des variables pour les mettre au format attendu par Grafana.

Ex coté InfluxDB 2.0 OSS / Flux :

from(bucket: v.bucket)

|> range(start: v.timeRangeStart, stop: v.timeRangeStop)

|> filter(fn: (r) => r["_measurement"] == "net")

|> filter(fn: (r) => r["_field"] == "bytes_recv" or r["_field"] == "bytes_sent")

|> filter(fn: (r) => r["host"] == v.host)

|> derivative(unit: v.windowPeriod, nonNegative: false)

|> yield(name: "derivative")

La version dans Grafana :

from(bucket: "${bucket}")

|> range(start: v.timeRangeStart, stop: v.timeRangeStop)

|> filter(fn: (r) => r["_measurement"] == "net")

|> filter(fn: (r) => r["_field"] == "bytes_recv" or r["_field"] == "bytes_sent")

|> filter(fn: (r) => r["host"] == "${host}")

|> derivative(unit: v.windowPeriod, nonNegative: false)

|> yield(name: "derivative")

La différence portant sur la gestion des variables v.host vs "${host}" et v.bucket vs "${bucket}".

Autre bonne nouvelle, les variables sont supportées dans Grafana ; vous pouvez donc définir les variables comme celles vu juste au-dessus :

Variable bucket de type “Query” en prenant InfluxDB/Flux comme datasource :

buckets()

|> filter(fn: (r) => r.name !~ /^_/)

|> rename(columns: {name: "_value"})

|> keep(columns: ["_value"])

Variable host de type “Query” en prenant InfluxDB/Flux comme datasource :

# Provide list of hosts

import "influxdata/influxdb/schema"

schema.tagValues(bucket: v.bucket, tag: "host")

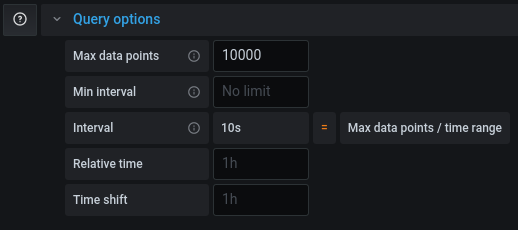

Si votre requête fonctionne dans un dashboard InfluxDB ou en mode explore mais qu’elle est tronquée dans Grafana, il vous faudra ajuster le “Max Data Points” pour récupérer plus de points pour cette requête (cf grafana/grafana#26484).