CérénIT

Le blog tech de Nicolas Steinmetz (Time Series, IoT, Web, Ops, Data)

Web, Ops & Data - Avril 2020

traefikscalewaykubernetestelegrafcassandrakafkaconfluenthelminfluxdbwarp10timescaledbdocker-composeapache-pulsarpubsubdeprek8conftestoparaspberrypigitlabsidecarCode et Outillage

- 18 GitLab features are moving to open source : Gitlab va rendre disponible dans sa version Open Source 18 fonctionnalités de sa version payante. C'est un peu la lutte avec Github et ses Github Actions ou ses dernières évolutions tarifaires.

Container & orchestration

- Announcing the Compose Specification : Docker Inc vient de lancer une spécificiation officielle autour de Compose (celle derrière les

docker-compose.yml) pour la rendre plus "cloud native" et plus générique avec une extension au provider cloud d'une part et d'autre part à des solutions comme kubernetes ou Amazone ECS par ex. - Announcing Traefik 2.2, ainsi que la version Entreprise TraefikEE 2.1 basée dessus : on notera le retour du support des annotations pour gérer les Ingress, le support de l'UDP (en plus de HTTP et TCP), le support d'Elastic APM, le support des stores KV (Consul, Etcd, Redis, etc) et le Dark Mode.

- Scaleway Kubernetes Kapsule : l'offre managée kubernetes de Scaleway est disponible. Dommage que les CPU des profils de machine

DEV*soient surprovisionnés et qu'il faille envisager des profilsGP*pour avoir des performances correctes. L'offre est du coup moins compétitive en termes de prix pour des petits clusters. - Kubernetes 1.18 : Fit & Finish : une version de consolidation

- How to detect outdated Kubernetes APIs : présentation de Deprek8 et de Conftest pour vous permettre d'évaluer les ressources kubernetes pour lesquelles vous n'êtes pas à jour au niveau des API.

- Helm 3.2.0 avec un correctif de sécurité sur les versions 3.0.x et 3.1.x et d'autres améliorations (comme le retour de certaines fonctionnalités non encore migrées depuis la 2.x)

- Cortex v1.0 released: The highly scalable, fast Prometheus implementation is generally available for production use : la solution de monitoring distribuée et avec un stockage de long terme basée sur Prometheus arrive en version 1.0. C'est l'occasion de se repencher sur son architecture et son fonctionnement.

- Build your very own self-hosting platform with Raspberry Pi and Kubernetes : une série d'articles pour déployer un cluster kubernetes sur vos raspberrypi avec la distributions k3s et y déployer différentes applications.

- Rook v1.3: Storage Operator Improvements : si vous n'êtes pas dans un environnement cloud, il y a de fortes chances pour que vous utilisiez Rook. La version 1.3 vient de sortir et apporte son lot d'améliorations.

- Sidecar container lifecycle changes in Kubernetes 1.18 : dans la version 1.19, le cycle de vie des sidecars dans kubernetes sera améliorée. Ainsi, ils démarreront avant le conteneur principal et s'arrêteront après. Le billet revient sur les problèmes existant et comment ce nouveau cycle de vie va améliorer la situation.

(Big) Data

- Confluent Raises $250M and Kicks Off Project Metamorphosis : Confluent, la soéciété éditrice de la Confluent Platform et d'Apache Kafka, vient de lever 250 millions de dollars et annonce le projet Metamorphosis et prévoit des annonces tous les mois sur Apache Kafka, Confluent Platform et ce projet à compter du mois de Mai. On en reparlera très certainement sur BigData Hebdo.

- Cassandra: The Definitive Guide, 3rd Edition : nouvelle édition de l'ouvrage de référence sur Cassandra, mis à jour notamment pour Cassandra 4.0 (version à venir)

- Announcing Kafka-on-Pulsar: bring native Kafka protocol support to Apache Pulsar : On en parle dans le prochain épisode de BigData Hebdo, mais Pulsar est une plateforme vraiment intéressante (Pulsar 101 en français ou en anglais) et les équipes d'OVHCloud viennent de publier un connecteur qui permet d'utliser l'API Kafka mais que les messages soient stockés dans Pulsar. Il existe aussi une vidéo sur Kafka on Pulsar et un article sur le blog d'OVHCloud.

Time Series

- Release Announcement: Telegraf 1.14.0 : 9 nouveaux inputs, 3 nouveaux processors et 1 nouvel output warp10 sont au programme de cette version. Les versions 1.14.1 et 1.14.2 sont sorties également avec quelques corrections.

- Release Announcement: InfluxDB 1.8.0 with Long-Awaited Features : la branche 1.x d'InfluxDB se voit donc dotée d'une version récente de flux qui se veut "production ready" et les endpoints d'InfluxDB 2.x sont aussi disponibles. Ce qui permet d'utiliser les nouveaux clients officiels InfluxDB prévus pour la 2.x d'une part et de faire des requêtes en Flux d'autre part.

- Release Announcement: InfluxDB 2.0.0 Beta 9 : mise à jour de Flux, autocomplétion flux dans l'éditeur de requêtes et amélioration de la CLI.

- InfluxDB Templates: Easily Share Your Monitoring Expertise : le billet a pour intérêt de présenter des bonnes pratiques sur la réalisation de templates InfluxDB. Pour rappel, les templates InfluxDB sont des "ressources" que l'on peut déclarer, exporter et importer dans une instance InfluxDB 2.x. Cela concerne des variables, labels, tasks, dashboards, alertes, etc.

- April 2020: Warp 10 release 2.5.0 : La version 2.5 de Warp10 apporte notamment un Accelerator c'est à dire un cache en mémoire pour les versions standalones. D'autres corrections et améliorations font également partie de cette release.

- WarpScript ❤️ Kafka Streams : si vous utiliser Kafka Streams et que vous voulez utiliser Warpscript pour consommer, processer et envoyer des données vers Kafka, c'est possible.

- Forecasting : Microsoft publie des exemples et des bonnes pratiques autour de la prévision à base de séries temporelles. Il y a des exemples en Python / R et quelques exemples avec Azure-ML.

- TimescaleDB 1.7: fast continuous aggregates with real-time views, PostgreSQL 12 support, and more Community features : Nouvelle version de TimeScaleDB apportant la compatibilité avec Postgresql 12.x, des aggrégats en temps réel et des fonctionnalités de gestion de données (réordonnancement et rétention) de la version Entreprise sont maintenant disponibles dans la version Community.

Web

- jQuery 3.5.0 Released! : une faille XSS a été identifiée sur

jQuery.htmlFilterpour toutes les versions inférieures à 3.5.0 ; il est vivement encouragé de mettre à jour vos sites. Pour le reste, je vous renvoie à la lecture de l'article.

Web, Ops & Data - Mars 2020

ansiblemoleculetestjavaredistimeseriesinfluxdbwarp10IaC

- Ansible Molecule 3.0 : l'outil de test des rôles Ansible est passé en version 3.0. Pas mal de changement avec l'externalisation des providers d'infrastructure sous la forme de module python et d'autres rationalisation. Une check list de migration est disponible

Langages

- What Tens of Millions of VMs Reveal about the State of Java : NewRelic publie une synthèse des versions et configuration de Java déployées dans la nature. ~85% tourne encore sur Java 8 et 11% sur Java 11 et le tout principalement avec les versions fournies par Oracle. On se moquait des communautés PHP (pour PHP 5 à PHP 7) ou Python (2 vers 3) mais visiblement chaque langage d'un certain age rencontre les mêmes soucis.

Time Series

- RedisTimeSeries Version 1.2 Is Here! : ce module qui apporte des fonctionnalités de séries temporelles à Redis (sans pour autant en faire une base de données orientée séries temporelles) passe en 1.2. On y trouve surtout des améliorations au niveau de la compression des données, des améliorations de performance et une rationnalisation de l'API.

- SenX publie un guide indiquant les propriétés d'une base de donnée timeseries et comment Warp10 se positionne sur les différents axes. Un joli travaille pédagogique.

- Warp10 a dépassé les 1000 fonctions

- InfluxDB 2.0 - beta 6 : améliorations de l'ensemble et l'apparition des premières fonctions géospatiales dans Flux.

- Le site du Paris Time Series Meetup est en ligne ; à défaut de meetup, vous pourrez y retrouver les vidéos et supports des précédentes éditions.

Paris Time Series Meetup - Edition 4 et 3

timeseriesinfluxdbmeetupptsmtelegraffluxtslredistimeseriesredisL'édition 4 du Paris Time Series Meetup s'est tenue hier soir. J'ai eu le plaisir d'accueillir David McKay, Developer Advocate InfluxData, qui est venu nous présenter la plateforme InfluxDB 2.0, le nouveau langage Flux et l'outil de collecte Telegraf (et les bonnes pratiques associées).

Vous pouvez d'ores et déjà retrouver les vidéos en ligne ; les présentations sont en anglais :

Et pour les ressources complémentaires mentionnées par David McKay :

Concernant l'édition 3 sur TSL et RedisTimeSeries, initiallement prévue en décembre 2019 et replanifiée le 21 janvier, elle aura finalement lieu le mercredi 25 Mars chez OVHCloud. Pour alimenter votre attente et comme indiqué dans le dernier billet de veille mensuelle, OVHCloud a publié erlenmeyer et vient de publier un billet de blog sur le sujet : TSL (or how to query time series databases).

Nous espérons vous y voir nombreux et en attendant, bon visionnage et bonne lecture !

Web, Ops & Data - Janvier 2020

timeseriescloudovhs3object storagedeltagitdifffaascontainerdraspberrypidockerinfluxdbvscodefluxwarp10observabilitédockercnabpostgresqlgrafanaMeilleurs voeux à tous pour cette nouvelle année !

Cloud

- OVHcloud Object Storage clusters support S3 API : pour ceux qui ne voulaient pas aller chez OVH car leur système de stockage objet est basé sur Openstack/Swift et ne voulaient pas modifier leurs appels d'API S3, une bonne nouvelle : le stockage objet d'OVH Cloud supporte l'API S3.

Container & Orchestration

- Managing the TICK Stack with Docker App : cet article aurait pu être dans la section Time Series mais le focus étant sur Docker et Docker App, il sera dans la section Container. L'article montre comment déployer la stack TICK (Telegraf, InfluxDB, Chronograf et Kapacitor) tout d'abord via un fichier

docker-compose.ymlet ensuite il montre les apports de Docker App, qui permet d'avoir un niveau de personnalisation supplémentaire. Ainsi, on peut avoir un seul fichier docker-compose.yml de référence et auquel on rajoute un fichier avec des propriétés par environnement ou par client ou par instance par ex. Une combinaison intéressante pour améliorer l'industrialisation de vos containers. - Kubernetes 1.17 disponible sur l'offre kubernetes managé d'OVHCloud

DevOps/SRE

- The 3 Myths of Observability : l'observabilité ne va pas directement baisser votre nombre d'incidents, l'observabilité n'est pas qu'une suite d'outils et elle n'est pas gratuite.

Outillage

- delta : pour améliorer le rendu de vos diff et certaines commandes git (diff, show, log, stash, reflog). L'outil est réalisé en rust. Cela donne un rendu à la github/gitlab dans votre console. Sympa !

Raspberry Pi

- faasd - lightweight Serverless for your Raspberry Pi : si vous jugez k3s encore trop gros pour vos raspberry pi pour faire tourner OpenFaaS ou que vous ne voulez pas déployer du kubernetes, vous pourriez trouver la solution du coté de faasd. Une implémentation du projet basée sur containerd (le runtime utilisée par Docker)

- HypriotOS v1.12.0 : la distribution optimisée pour Raspberry Pi et fournissant Docker arrive en version 1.12. Elle permet d'utiliser Docker sur tous les modèles de Raspberry (0, 1, 2, 3, 4) avec les dernières versions de docker, docker-compose et docker-machine.

SQL

- Améliorez votre SQL : utilisez des index filtrés : Postgresql permet de définir des index filtrés : plutôt que de créer un index sur toutes les données d'une table, vous pouvez définir un index qui répond à un filtre et ne faire un index que sur ce sous-ensemble de données.

Time Series

- Grafana v6.6 Released : nouvelle version de Grafana avec comme d'habitude plein d'améliorations à tous les étages (data source, panels, alerting, explore, etc)

- Release Announcement: Flux VSCode Support : InfluxData a publié une extension VSCode pour le langage flux.

- InfluxDB 2.0 Open Source Beta Released : InfluxData passe la version OSS d'iInfluxDB 2.0 en béta après une année de versions alpha. On y trouve notamment une approche Configuration As Code avec la possibilité de définir des Tasks, Dashboards, ainsi que de la configuration via des Manifest en YAML et un système de packages. Flux, le nouveau langage de requêtage continue à s'améliorer et enfin le transpiler InfluxQL vers Flux fait son entrée mais demande à s'améliorer au fil du temps. La beta 2 est sortie aussi.

- telegaf warp10 output : la prochaine version de Telegraf supportera nativement Warp10.

- Erlenmeyer: Time Series query translator : OVHCloud vient d'opensourcer le code de leur proxy en go qui leur permet de parser des requêtes de différentes bases de données time series (OpenTSDB, PromQL, Prometheus Remote Read, InfluxQL et Graphite) en Warpscript pour requêter les données stockées dans Warp10. Pour rappel, la solution OVHMetrics est basée sur Warp10.

- Le traitement et l'utilisation de la data dans l'industry 4.0 : SenX, la société éditrice de Warp10, a réalisé une vidéo intéressante sur le traitement et l'utilisation de la data dans l'industrie 4.0. On y voit notamment les 4 niveaux de maturité quant à la donnée et le rôle d'une base de données temporelles dans ce contexte. Un billet de blog (en anglais) est également disponible.

Web, Ops & Data - Décembre 2019

influxdbdockerkubernetestraefikgrafanadashboardcassandrareaperwarp10timeseriestimescaledbhelmmachine-learningRendez-vous le 21 janvier prochain à la troisième édition du Paris Time Series Meetup consacré à TSL (billet introductif à TSL : TSL: a developer-friendly Time Series query language for all our metrics) et le module RedisTimeSeries qui apporte des fonctionnalités et des structures Time Seriies à Redis. Le meetup était prévu initialement le mardi 17 décembre mais a été reporté du fait des grèves.

Container et orchestration

- DockerSlim : le projet vise à réduire la taille de vos images et à améliorer leur sécurité en procédant à différentes optimisations. Cela peut être intéressant dans une stratégie d'améliorations de vos images docker mais à tester néanmoins. Les exemples données partent d'Ubuntu 14.04 dont l'image fait 60 / 65 Mo alors que l'image Ubuntu 16.04 fait moitié moins et Alpine fait 30 fois moins. Donc certains gains semblent faciles à obtenir, à creuser plus en détail.

- Kubernetes 1.17: Stability : après une version 1.16 marquée notamment par la dépréciation de certaines APIs, cette version se veut plus une consolidation autour des "Cloud Provider Labels" qui passent en GA, le snapshot de volumes qui passe en beta, ainsi que la couche de stockage CSI avec la poursuite de la migration des plugins "in-tree" vs "out-of-tree". La fin de cette migration est prévue pour les versions 1.19 / 1.20 et le retrait complet des plugins "in-tree" pour les versions 1.21 / 1.22.

- A visual guide on troubleshooting Kubernetes deployments : un guide du troublehooting des déploiements sous kubernetes avec un joli diagramme des cas possibles et les explications associées en repartant d'un exemple simple.

- How to migrate from Helm v2 to Helm v3 : les opérations à mener pour migrer de Helm V2 à Helm V3.

- Traefik 2.1 : le provider Consul Catalog fait son retour (il était absent en 2.0.x) et diverses améliorations sur la CRD Kubernetes ont été apportées pour mieux gérer le mirroring du traffic, les déploiements canary et la gestion des sessions. La migration ne consistant pas seulement à changer le numéro de version et suite à une remarque de ma part, une note a été ajoutée pour la migration 2.0.x vers 2.1.x

Dataviz

- Pro Tips: Dashboard Navigation Using Links : améliorer vos dashboards Grafana avec des liens à différents niveaux dans l'interface pour pointer vers des ressources utiles.

NoSQL

- Cassandra Reaper 2.0 was released : la solution de réparation de vos clusters Cassandra passe en 2.0 ; elle apporte un déploiement en mode sidecar (reaper est lancé dans la même jvm que Cassandra), le support d'Apache Cassandra 4.0 (pas encore officiellement disponible), de nouveaux thèmes, une amélioration du support de Postgresql comme backend de déploiement et pleins d'autres choses.

Time Series

- Release Announcement: InfluxDB 2.0.0 Alpha 21 : Cette version alpha apporte notamment le début de la transpilation des requêtes InfluxQL en Flux. C'est peut être un des plus gros enjeux pour la migration entre la version 1.x et 2.x d'InfluxDB et la gestion de l'écosystème associé.

- Warp 10™ release 2.3.0 : la plateforme Warp10 continue son chemin avec une fonctionnalité intéressante permettant de mieux définir les points que l'on veut récupérer pour une requête donnée (nombre de points, échantillonage, points du début et de fin, etc)

- Motion Split : Présentation d'une autre fonctionnalité intéressante de Warp10 2.3.0 si vous suivez des objets qui se déplacent et que vous voulez définir des groupes de points en fonction d'un délai, d'une distance, d'arrêts.

- New: Helm Charts for deploying TimescaleDB on Kubernetes : pour ceux qui utilisent TimescaleDB, des charts helm sont à votre disposition pour déployer une instance, avec gestion de la réplication des données.

- Time series features extraction using Fourier and Wavelet transforms on ECG data : Application de la théorie des signaux sur des séries temporelles dans le cadre d'analyse d'électrocardiogramme. Cela complète les articles du mois précédent.

Je n'ai plus qu'à vous souhaiter des bonnes fêtes de fin d'année ; nous nous retrouvons l'année prochaine !

Exporter les métriques Traefik dans InfluxDB dans un contexte Kubernetes

kubernetestraefikinfluxdbmétriquetimeseriesTraefik, depuis sa version V1, permet d'envoyer des métriques vers différents backends (StatsD, Prometheus, InfluxDB et Datadog). J'ai enfin pris le temps d'activer cette fonctionnalité et de creuser un peu le sujet étant donné que le dashboard de Traefik V2 n'affiche plus certaines de ses statistiques.

La documentation de Traefik sur le sujet :

Commençons par créer une base traefik dans InfluxDB (version 1.7.8)

influx

Connected to http://localhost:8086 version 1.7.8

InfluxDB shell version: 1.7.9

> auth

username: XXX

password: XXX

> CREATE DATABASE traefik

> CREATE USER traefik WITH PASSWORD '<password>'

> GRANT ALL ON traefik to traefik

> SHOW GRANTS FOR traefik

database privilege

-------- ---------

traefik ALL PRIVILEGES

> quit

Dans mon cas, l'accès à InfluxDB se fait en https au travers d'une (autre) instance Traefik. J'utilise donc la connexion en http plutôt qu'en udp.

Cela donne les instructions suivantes en mode CLI :

--metrics=true

--metrics.influxdb=true

--metrics.influxdb.address=https://influxdb.domain.tld:443

--metrics.influxdb.protocol=http

--metrics.influxdb.database=traefik

--metrics.influxdb.username=traefik

--metrics.influxdb.password=<password>

J'ai gardé les valeurs par défaut pour addEntryPointsLabels (true), addServicesLabels (true) et pushInterval (10s).

Cela donne le Deployment suivant :

apiVersion: apps/v1

kind: Deployment

metadata:

name: traefik2-ingress-controller

labels:

k8s-app: traefik2-ingress-lb

spec:

replicas: 2

selector:

matchLabels:

k8s-app: traefik2-ingress-lb

template:

metadata:

labels:

k8s-app: traefik2-ingress-lb

name: traefik2-ingress-lb

spec:

serviceAccountName: traefik2-ingress-controller

terminationGracePeriodSeconds: 60

containers:

- image: traefik:2.0.6

name: traefik2-ingress-lb

ports:

- name: web

containerPort: 80

- name: admin

containerPort: 8080

- name: secure

containerPort: 443

readinessProbe:

httpGet:

path: /ping

port: admin

failureThreshold: 1

initialDelaySeconds: 10

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 2

livenessProbe:

httpGet:

path: /ping

port: admin

failureThreshold: 3

initialDelaySeconds: 10

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 2

args:

- --entryPoints.web.address=:80

- --entryPoints.secure.address=:443

- --entryPoints.traefik.address=:8080

- --api.dashboard=true

- --api.insecure=true

- --ping=true

- --providers.kubernetescrd

- --providers.kubernetesingress

- --log.level=ERROR

- --metrics=true

- --metrics.influxdb=true

- --metrics.influxdb.address=https://influxdb.domain.tld:443

- --metrics.influxdb.protocol=http

- --metrics.influxdb.database=traefik

- --metrics.influxdb.username=traefik

- --metrics.influxdb.password=<password>

Appliquer le contenu du fichier dans votre cluster Kubernetes

kubectl apply -f deployment.yml -n <namespace>

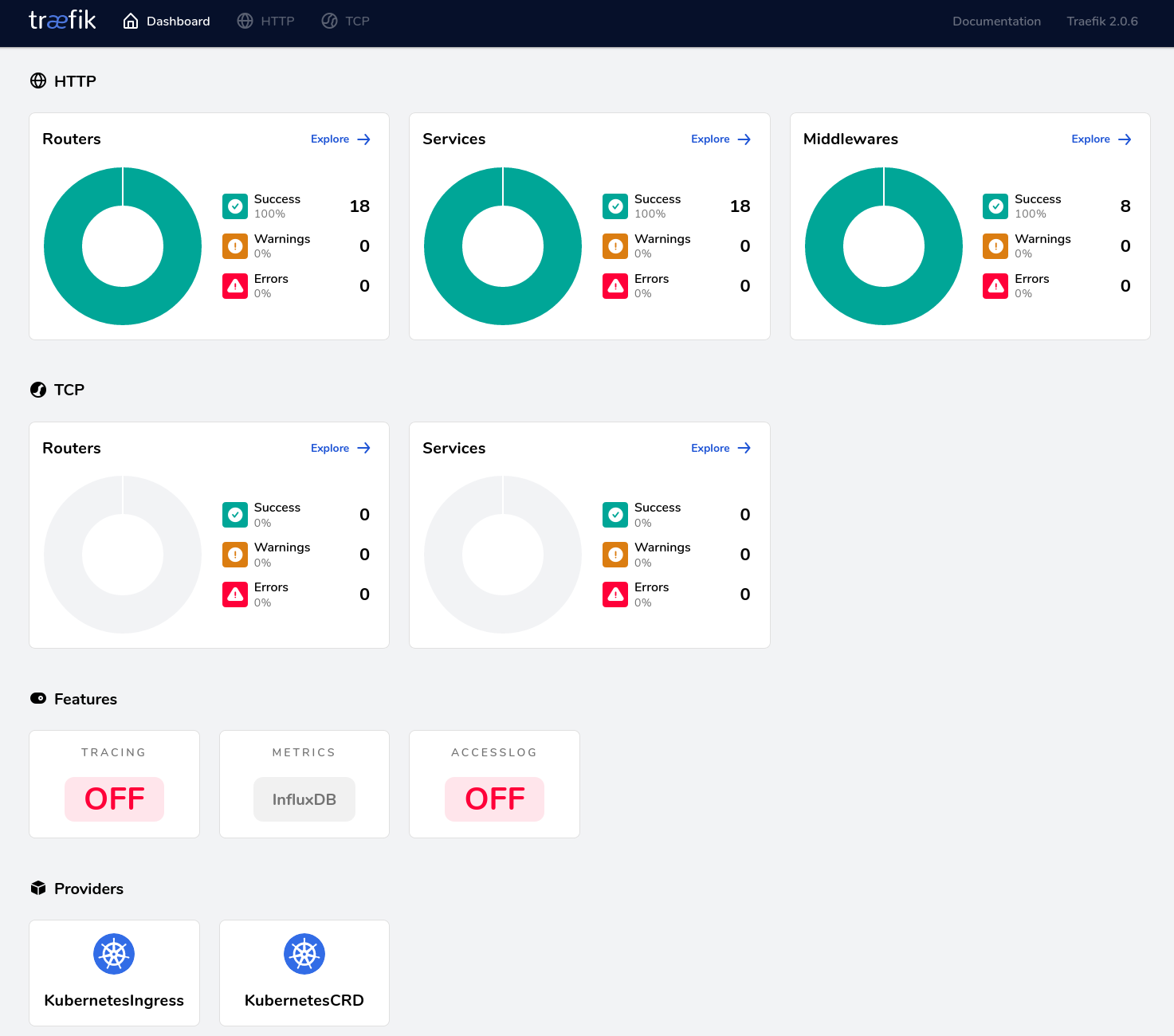

Sur le dashboard Traefik, dans la section "Features", la boite "Metrics" doit afficher "InfluxDB", comme ci-dessous :

Vous pouvez alors vous connecter à votre instance InfluxDB pour valider que des données sont bien insérées :

influx

Connected to http://localhost:8086 version 1.7.8

InfluxDB shell version: 1.7.9

> auth

username: traefik

password:

> use traefik

Using database traefik

> show measurements

name: measurements

name

----

traefik.config.reload.lastSuccessTimestamp

traefik.config.reload.total

traefik.entrypoint.connections.open

traefik.entrypoint.request.duration

traefik.entrypoint.requests.total

traefik.service.connections.open

traefik.service.request.duration

traefik.service.requests.total

Il ne vous reste plus qu'à utiliser Chronograf ou Grafana pour visualiser vos données et définir des alertes.

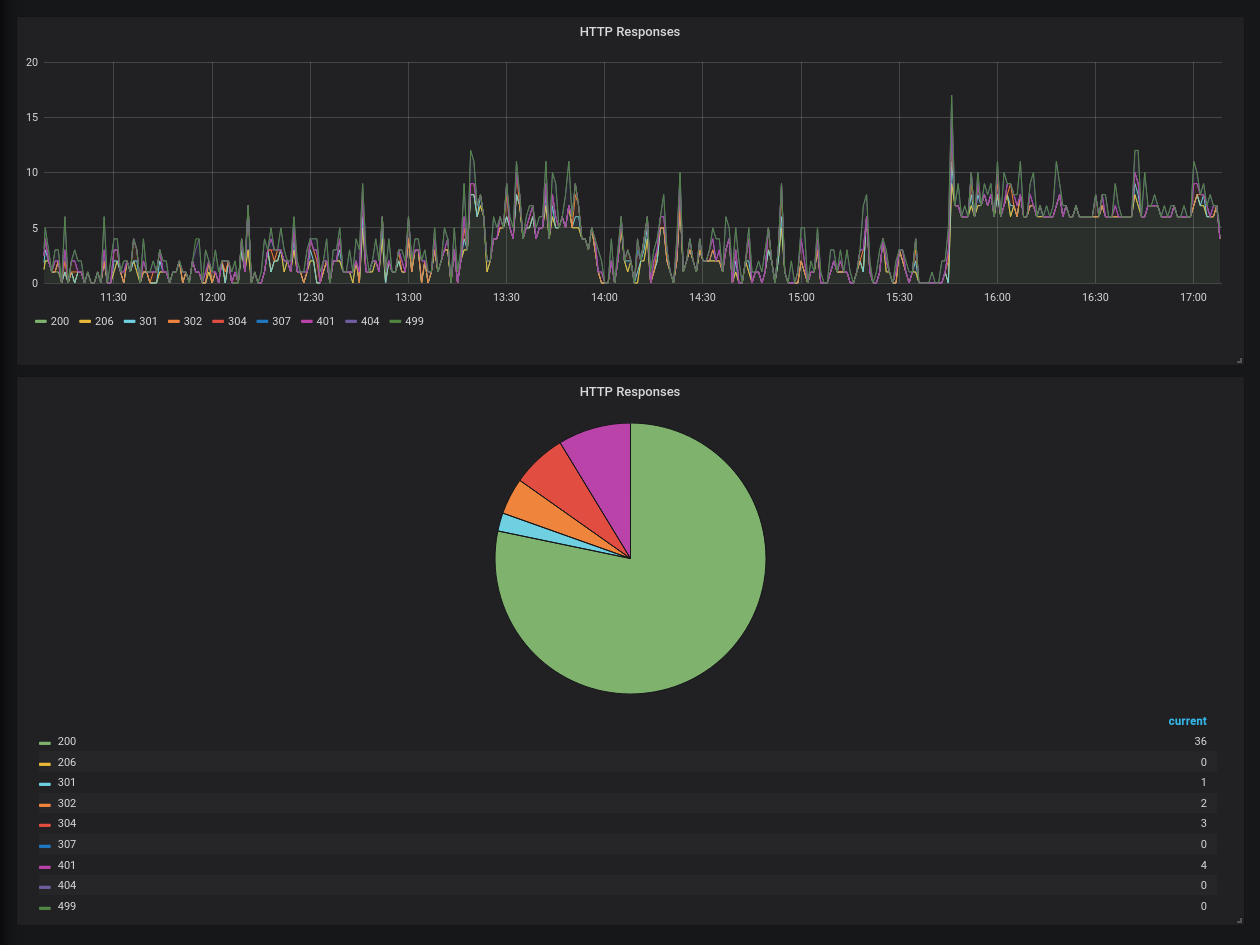

Un exemple rapide avec la répartition des codes HTTP dans Grafana :

Web, Ops & Data - Aout 2019

gitlabcicdcontinous integrationcontinous deploymentgitdiffdockerrpitraefikkubernetesovhhelmpostgresperconaawspartiqlredistimeseriesinfluxdbkafkaprometheusSurveillez le Time Series Paris Meetup, car la première édition du Meetup sera annoncée mardi avec une présentation des usages avancées des séries temporelles avec Warp10 (comprendre au-delà du monitoring classique) et une présentation par les équipes OVH sur du monitoring de datacenter aidé par du machine learning et leur offre Préscience.

CI/CD

- How to trigger multiple pipelines using GitLab CI/CD : depuis une pipeline d'un dépôt gitlab, il va être possible d'appeler les pipelines des autres projets gitlab. Une fonctionnalité intéressante et qui pourrait lever la dépendance à Jenkins lorsque l'on a des pipelines un peu complexes et inter-projets.

- New up and coming GitLab CI/CD Features : bilan et perspectives par le responsable produit de gitlab sur les fonctionnalités CI/CD qui ont été rajoutées cette année et celles à venir.

Code

- Highlights from Git 2.23 : Tentative de remplacement de

git checkoutpargit switchetgit restorepour mieux encadrer les usages - Create Git diffs with proper function context : améliorer vos diff git avec une meilleure prise en compte du langage avec lequel vous travaillez.

Conteneurs & orchestration

- Releasing HypriotOS 1.11.0: Docker 19.03.0 CE from Raspberry Pi Zero to 4 B : la distribution HypriotOS, pour raspberry pi, sort une nouvelle version avec les dernières versions de docker, docker-compose, etc.

- OVH 1.15 Certified : Le service managé kubernetes d'OVH passe en version 1.15

- Traefik Release: v2.0.0-beta1 & Traefik Release: v2.0.0-rc1 : Traefik 2.0 commence à pointer le bout de son nez et les connecteurs docker / kubernetes notamment sont prêts, ainsi que plein d'autres choses.

- Helm 3.0.0-beta.1 : Helm 3.0 émerge doucement et on commence à se rendre compte des petits changements qui vont arriver...

SQL

- Percona Distribution for PostgreSQL 11 (Beta) Is Now Available : Percona est connu pour son expertise autour de MySQL, de leur serveur et des outils qu'ils ont créés autour. Ils semblent vouloir faire la même chose avec Postgres. Cela semble prometteur !

- Announcing PartiQL: One query language for all your data : AWS lance un langage visant à être un requêteur universel de données structurées et non structurées en SQL. C'est en open source et pour le moment cela traite surtout les données des services AWS, ainsi que Couchbase.

time series

- RedisTimeSeries GA – Making the 4th dimension truly immersive : RedisLabs met à disposition un module permettant d'améliorer l'expérience utilisateur des développeurs manipulant des séries temporelles dans Redis. Ce module n'a a priori pas pour vocation à ce stade d'intégrer le coeur du produit.

- How Hulu Uses InfluxDB and Kafka to Scale to Over 1 Million Metrics a Second : retour d'expérience sur l'utilisation d'influxdb et kafka chez Hulu pour ingérer et apporter de la résilience à leurs données temporelles.

- How to use Prometheus for anomaly detection in GitLab : retour d'expérience de gitlab sur l'utilisation de Prometheus dans un contexte de détection d'anomalies.

InfluxDays London 2019

influxdaysinfluxdbinfluxcloudtimeseriestickinfluxdatainfluxaceLa cinquième édition des InfluxDays (et la seconde édition en Europe) s'est tenue à Londres les 13 et 14 juin 2019. Les InfluxDays sont organisés par la société InfluxData, éditrice des produits Telegraf, InfluxDB, Chronograf et Kapacitor, connu aussi sous le nom de la stack TICK. Il s'agit d'une plateforme de gestion des données temporelles, depuis leur ingestion jusqu'à leur visualisation et leur traitement en passant par leur stockage. Durant ces deux jours, des présentations portent sur les produits, leurs évolutions, des retours d'expériences clients et plus généralement sur l'écosystème.

Sur InfluxData, quelques chiffres :

- 230.000 installations d'InfluxDB dans le monde

- 200+ plugins telegraf (agent de collecte)

- 600+ clients InfluxData

- 140+ employés

Avant de rentrer dans la synthèse, il faut que vous sachiez que j'ai été nominé "InfluxAce" pour la France. Ce titre permet à InfluxData de reconnaitre et promouvoir les experts de la stack TICK et de les remercier pour leur contribution à la communauté et à l'évangélisation de leurs produits. Deux autres personnes en Belgique et au Luxembourg ont été nominées également.

Si vous voulez un résumé assez détaillé, je vous invite à lire celui d'Antoine Solnichkin (en anglais) qui n'est autre que notre InfluxAce luxembourgeois.

Les principaux enseignements pour moi d'InfluxDays :

- Influx 2.0 : de la stack TICK à une plateforme unifiée : en réintégrant les fonctionnalités de visualisation et de traitement des données dans la base elle-même, les composants "ICK" deviennent un produit unifié et plus intégré. L'idée est de pouvoir manipuler ses données très rapidement sans avoir à installer et paramétrer plusieurs composants. Telegraf n'est pas en reste car la configuration pourra être générée depuis Influx 2.x et Telegraf pourra même récupérer sa configuration via l'API.

- Influx 2.0 : une plateforme composable et extensible : en adoptant une approche API first (en plus d'avoir été unifiée et rendue plus cohérente entre les produits), InfluxData permet des intégrations plus aisées et met aussi une CLI ou un REPL plus riches à disposition de ses utilisateurs. InfluxData travaille aussi sur l'extensibilité de sa solution via des "packages" pour Flux et Telegraf notamment. Ces packages permetteront d'apporter sa propre logique dans la plateforme (plugins telegraf pour la collecte des données, fonctions flux pour le traitement des données, modèles de dashboards, modèles de tâches, etc).

- Influx 2.0, une plateforme "... as Code" : la solution étant extensible et une API permettant d'interagir avec elle, il sera donc possible de versionner de versionner le code des différents éléments et de les déployer via l'API proposée par Influx. Des mécanismes de templates vont aussi permettre aux utilisateurs de ne pas démarrer avec l'angoisse de la feuille vide mais au contraire d'avoir des bonnes pratiques ou des règles de gouvernance sur la façon de gérer les données.

- Influx 2.0, un hub pour vos données temporelles : Flux, le nouveau langage pour interagir avec les données, se veut être en mesure de résoudre les limites d'InfluxQL sur la manipulation des données temporelles mais aussi de pouvoir aller requêter des sources de données tierces dans le cadre de l'enrichissement / le nettoyage des données. Des réflexions sur la gestion de datasources plus traditionnelles est en cours. Flux va également être en mesure de s'interfacer avec d'autres sources de données comme Prometheus (dont une démonstration du transpiler a été faite). Cette capacité de transpilation peut ainsi permettre de connecter Grafana à Influx 2.x via une datasource Prometheus et de continuer à avoir des requêtes PromQL. De la même façon, Flux pourrait être utilisé pour permettre la migration Influx 1.x vers Influx 2.x par ex sous Grafana sans avoir à toucher aux requêtes de ses dashboards.

- Influx (2.0), c'est en fait trois produits avec du code partagé entre eux : InfluxDB OSS, InfluxDB Entreprise et InfluxCloud. La version cloud devrait passer en production cet été, Influx 2.x OSS devrait passer en bêta cet été et finir en GA fin 2019 / début 2020 et Influx 2.x Entreprise arrivera en 2020. InfluxCloud se déploie sur Kubernetes et chaque composant est modulaire et scalable et s'appuie aussi sur Kafka quand InfluxDB OSS 2.x restera un binaire unique en Go.

D'autres présentations ont permis de mieux comprendre le moteur de stockage d'InfluxDB, comment faire un plugin Telegraf ou bien d'avoir des retours clients intéressants.

Au final, et indépendamment de ma nomination, ce fut deux jours très intéressants pour mieux appréhender la plateforme, son fonctionnement interne, les évolutions à venir et voir différents cas d'utilisation. Ce fut enfin l'occasion de rencontrer les équipes InfluxData avec qui j'ai passé un très bon moment et il est toujours agréable de pouvoir poser ses questions au CTO et CEO d'InfluxData sur le produit ou le marché des données temporelles. Ce fut également très intéressant de discuter avec différents membres de la communauté.

Vous devriez pouvoir accéder aux vidéos et slides de l'événement via le site de l'événement d'ici quelques jours.

Un meetup "timeseries" va être organisé en France entre septembre et la fin d'année par votre serviteur et avec le support d'InfluxData.. Si vous êtes intéressés, inscrivez-vous au meetup "Paris Time Series Meetup". Il se veut ouvert à tout l'écosystème des séries temporelles et si vous avez des idées/envies/..., n'hésitez pas à me contacter ou via le Meetup ou encore twitter.

Web, Ops & Data - Avril 2019

influxdbtimescaledbtraefikkubernetesssh-agentpostgresrecherchedockerloggoogle cloud nextserverlessapmglowrootdocker registryDeux petites annonces pour démarrer cette édition :

- Je serai à KubeCon EU du 20 au 23 Mai à Barcelone. Si vous y allez aussi, dites le moi, ce sera une occasion de se rencontrer.

- Le BigData Hebdo a ouvert son slack - Vous pouvez nous rejoindre par vous même via ce lien

APM

- Glowroot : Pour ceux qui s'intéressent au sujet de l'APM et qui ne veulent pas aller chez AppDynamics, Dynatrace ou Elastic, j'ai assisté à une démo intéressante sur Glowroot - il est forcément moins riche que ces concurrents mais il a l'air de faire l'essentiel de ce que l'on peut attendre d'un APM. Il ne marche qu'avec la JVM.

Cloud

- Big Data Hebdo - Episode 71 : Google Cloud Next 19 : Vincent et Jérome passent en revue les annonces de Google Cloud Next 2019, en plus de nous faire un analyse fine de MS Excel vs Google Sheets ;-) - Personnellement, je retiens surtout Anthos (le kubernetes distribué multi-cloud et on-premise), Cloud Run (la capacité à exécuter des conteneurs dans une logique serverless et basé sur knative - il me fait penser à OpenFaaS) et Cloud Code (extension pour l'IDE VSCode et prochainement IntelliJ pour gérer plus facilement des déploiements Kubernetes). Vous retrouvrez les 122 annonces sur le blog de Google Cloud et les vidéos sont sur la chaine Youtube associée

Container et Orchestration

- Kubernetes 1.14: Production-level support for Windows Nodes, Kubectl Updates, Persistent Local Volumes GA : les noeuds Windows et les conteneurs Windows sont supportés officiellement, kubectl se voit améliorer et bénéficie d'un nouveau site de documentation et se dote d'une intégration de kustomize. Les volumes locaux persistant passent en bêta et plein d'autres choses encore.

- Kubernetes 1.14: Local Persistent Volumes GA : les volumes locaux persistants sont intéressants car ils vont permettre de déployer un conteneur sur un même noeud de façon assurée dès lors que ce volume est défini. Cela n'est certes pas très résilient, mais cela peut réponre à un certain nombre de besoins. Les cas d'usages sont très bien décrits dans ce billet et peuvent donner des idées.

- Announcing General Availability of Traefik Enterprise Edition : la version Entreprise de Traefik est disponible officiellement. Elle adresse principalement le cas d'un déploiement haute disponibilité de Traefik avec la mise en place d'un data plane et d'un controle plane pour gérer tout ça.

- CNCF to Host CRI-O : le runtime de conteneurs développé par Red Hat et Google rejoint la fondation CNCF au stade de l'incubation.

- Introducing Kraken, an Open Source Peer-to-Peer Docker Registry : Uber vient de mettre à disposition Kraken, une "registry docker" pair à pair. Le nombre d'acteurs intéressés par ce genre de projet doit être assez faible mais sait-on jamais...

DevOps

- JSON as configuration files: please don’t : Si certains pensaient utiliser JSON pour décrire des fichiers de configurations, l'article rappelle que JSON n'est qu'un format d'échange de données et surtout pas de fichiers de configuration. On peut comprendre la tentation mais on a déjà bien assez à faire avec YAML, INI voire XML. Aucun n'est parfait certes mais pas la peine d'en rajouter.

- In Defense of YAML : L'auteur critique l'abus autour de YAML pour l'utiliser pour tout et n'importe quoi. Comme format de données, il est utilisable mais nous voyons des détournements où du yaml devient du pseudo code. L'auteur cite la CI Gitlab ou encore Tekton. On ne peut que lui donner raison. Il serait plus simpe d'avoir un vrai langage de programmation plutôt que de tout "YAMLiser".

Licences

- Deprecation Notice: MIT and BSD (via Les Cast Codeurs) : Intéressant, les licences BSD/MIT serait à considérer comme dépréciée. L'auteur travaille pour le Blue Oak Council qui publie la licence du même nom. On peut éventuellement lui reprocher un certain biais mais il indique quand même que des licences modernes (comme ASL 2.0) seraient plus judicieuses que de rester sur du MIT/BSD.

Sécurité

- Les serveurs de Matrix.org ont été compromis - l'équipe a joué la transaprence et donne les informations laissées par l'attaquant sur les failles existantes et les bonnes pratiques qu'il faut en déduire. C'est l'occasion de revoir notamment les options de ssh-agent pour éviter de telles mésaventures.

SQL

- La recherche plein texte avec Postgresql : Présentation des tsvector et tsquery, deux fonctions postgres pour faire de la recherche plein texte.

Timeseries

- Introducing Outflux: a smart way out of InfluxDB : l'équipe de TimescaleDB, l'extension Postgres qui permet de manipuler des données temporelles, sort son outil de migration des données d'InfluxDB vers TimescaleDB.

Astuce du mois : gestion de la rotation des logs d'un container docker

Dans les bonnes pratiques Docker, il est dit d'utliser stdout/stderr pour avoir les logs de votre conteneur via docker logs. Toutefois, cette pratique va alimenter un fichier de log /var/lib/docker/containers/<container id>/<conteiner id>-json.log. Ce fichier peut donc saturer votre disque et aller jusqu'à corrompre vos conteneurs. L'autre bonne pratique étant que tout fichier de log doit avoir une politique de rotation du fichier associée pour éviter toute saturation de disque ou d'avoir des trop gros fichiers de logs.

Docker permet de configurer le driver de logs au niveau du démon (via /etc/docker/daemon.json), en argument lors d'un docker run ou dans docker-compose.yml.

Si l'on reste sur le driver json-file et que l'on veut piloter la rotation des logs au niveau de docker-compose.yml, cela donne par ex (version simplifiée) :

version: '3'

services:

service_xxx:

image: docker_image_xxx

[...]

logging:

driver: "json-file"

options:

max-size: "10m"

max-file: "10"

Vous pouvez alors définir une stratégie de rotation des logs par container si vous le souhaitez. Ainsi, vous gérer la taille maximale de logs qui vont être générés et êtes ainsi assurés de ne pas avoir de mauvaises surprises à ce niveau là.

Web, Ops & Data - Septembre 2018

cassandradockerswarmpythonjquerylambdaansibleinfluxdbterraformhashicorpfacebookiaengineeringcloudAvant de commencer cette revue de presse, un peu d'auto-promo, vu que j'ai eu le plaisir et l'honneur de participer au numéro de rentrée (épisode 59) du BigData Hebdo.

Cloud

- Multi-Cloud Is a Trap : sujet à la mode, le multi-cloud selon l'auteur du billet est inutile/idiot et ne serait qu'une distraction/perte de temps et d'argent dans la plupart des cas ; certaines exceptions sont acceptées en fin de billet). Un point intéressant étant de dire qu'en voulant éviter le "lock-in", on se prive de profiter au maximum de la plateforme cloud et que l'on se créée du coup un coût de "lock-out".

Containers et Orchestration

- The Future of Docker Swarm : Etat des lieux et perspectives sur Swarm par un Capitaine Docker. Le projet n'est pas mort et il peut suffire dans bon nombre de cas.

- Docker Config, how to always use base image with Docker Swarm! : Depuis Docker 17.06 et dans un contexte Swarm, il est possibile d'utiliser les configs. Les configs permettent de stocker un fichier de configuration au sein du cluster swarm et de le mettre à disposition des containers. Ainsi, en cas des modifications de la configuration, plus besoin de rebuilder l'image, il suffit de mettre à jour le service pour qu'une nouvelle version du container la prenne en compte.

- Pros and Cons of running all Docker Swarm nodes as Managers? : Revue par le Docker Captain Bret Fisher des avantages/incovénients d'utiliser que des nodes de type "managers" au sein d'un cluster Swarm. Trop est déconseillé (> 5) et ensuite c'est un compromis entre la sécurité, la disponibilité et la résilience.

- Traefik 1.7 — Yet Another Slice of Awesomeness : dans les nouveautés principales : une image Docker pour windows, le support de l'authentification dans les frontends, le support d'AWS Fargate, HC2 Support et le support du challenge TLS pour Let's Encrypt (plus besoin d'avoir le port 80 ouvert). Apparemment pour la prochaine version, l'équipe de dév va prendre quelques libertés pour introduire des nouveautés - il faut donc s'attendre à quelques incompatibilités à l'avenir.

DevOps

- Ansible Tips : Reboot & Continue : Astuce utile pour gérer un reboot d'un serveur via ansible et reprendre ensuite la connexion et l'exécution du reste d'un playbook.

IA

- Finding and fixing software bugs automatically with SapFix and Sapienz : Sapienz et SapFix ne sont pas des produits SAP mais des projets Facebook. Le premier est un agent de test automatique et SapFix est une IA qui est en mesure d'identifier des correctifs pour les bugs identifiés par le premier. Le fix peut être un retour partiel ou total au code précédent mais aussi de prospoer des correctifs sur la base de modèle de code. Une fois les correctifs testés et qu'aucune régression n'est identifiée, alors le fix est proposé pour validation aux développeurs.

Ingénierie

- Software disenchantment : "That is not engineering. That’s just lazy programming. Engineering is understanding performance, structure, limits of what you build, deeply. Combining poorly written stuff with more poorly written stuff goes strictly against that. To progress, we need to understand what and why are we doing." - un plaidoyer pour de meilleures pratiques d'ingénierie partant du constat que les applications développées sont de plus en plus grosses, de moins en moins performantes pour un niveau de fonctionnalité à peine meilleur. Heureusement que les machines ont progressé pour compenser cette "obésité logicielle".

(No)SQL

- So you have a broken Cassandra SSTable file? : que faire lorsqu'une SSTable est corrmpue, c'est tout l'objet de cet article, de la plus simple et moins impactante à la plus complexe/impactante. Sans aller jusqu'à la corruption, nous avons eu un cas similaire et un

nodetool scrub <keysapce> <table>a été suffisant. - Incremental Repair Improvements in Cassandra 4 : les réparations incrémentales, déconseillées jusqu'alors par les gens de The Last Pickle, semblent devenir la solution recommandée avec la sortie prochaine de Cassandra 4.0. Les réprations complètes (full) ne seraient alors utiles que dans certains cas, car moins efficientes.

- Introducing cstar: The Spotify Cassandra orchestration tool, now open source : Spotify ouvre le code de son shell distribué pour Cassandra, sous le nom de cstar Il a pour intérêt d'être conscient de la topology du cluster et donc de pouvoir faire les commandes de façon optimisées.

- Architecture Lambda, Cassandra et synchronisation des données : après un petit rappel sur l'architecture lambda, l'article présente les différents patterns permettant de garantir qu’une donnée stockée dans Cassandra et pouvant être mise à jour de façon concurrente par un flux batch et un flux temps réel ait toujours la valeur la plus fraîche.

- Why We Built an Open Source Cassandra-Operator to Run Apache Cassandra on Kubernetes : Instaclustr propose un Operator Cassandra pour déployer plus faciment Cassandra sur Kubernetes.

- Terraform InfluxDB Module : InfluxData a annoncé un partenariat avec Hashicorp et le premier livrable est un module terraform permettant de déployer InfluxDB OSS ou Entreprise sur AWS.

(Open)Web

- Removing jQuery from GitHub.com frontend : Github raconte son adoption jusqu'au retrait de JQuery de sa base de code. Il est intéressant de voir que les standards ont permis de remplacer pas mal de fonctionnalités et il reste encore quelques polyfills.

- The Cost Of JavaScript In 2018 : l'utilisation de Javascript, en particulier sur mobile, n'est pas neutre. L'article revoit les bonnes et mauvaises pratiques.

- your web app is bloated : Etude sur la consommation de mémoire de différnts sites sous Firefox - cela va de 0.8Mo (Gmail Vintage) à 200 Mo (Google Inbox)

Python

- High-Performance in Python with Zero-Copy and the Buffer Protocol : astuce utile d'utiliser

memoryviewpour accélerer les accès aux données et éviter de l'usage inutile de mémoire.

Astuce du mois

J'ai cru à un bug ansible sur les surcharges de variables mais en fait non - pour des variables de même niveau (ici group_vars), l'ordre de fusion des variables est :

- “all.yaml” est chargé en premier

- Les autres fichiers yaml sont chargés par ordre alphabétique et s’écrase les uns les autres le cas échéant

Donc si on a :

all.yaml:

monitoring:

datadog: false

cassandra.yaml:

monitoring:

datadog: true

et infra.yaml:

monitoring:

datadog: false

alors datadog est à false à la fin lorsqu’on exécute le playbook.

A l’inverse:

all.yaml

monitoring:

datadog: false

infra.yaml:

monitoring:

datadog: false

swarm.yaml:

monitoring:

datadog: true

alors datadog est à true à la fin lorsqu’on exécute le playbook.

Sources :