CérénIT

Le blog tech de Nicolas Steinmetz (Time Series, IoT, Web, Ops, Data)

Exporter les métriques Traefik dans InfluxDB dans un contexte Kubernetes

kubernetes traefik influxdb métrique timeseriesTraefik, depuis sa version V1, permet d’envoyer des métriques vers différents backends (StatsD, Prometheus, InfluxDB et Datadog). J’ai enfin pris le temps d’activer cette fonctionnalité et de creuser un peu le sujet étant donné que le dashboard de Traefik V2 n’affiche plus certaines de ses statistiques.

La documentation de Traefik sur le sujet :

Commençons par créer une base traefik dans InfluxDB (version 1.7.8)

influx

Connected to http://localhost:8086 version 1.7.8

InfluxDB shell version: 1.7.9

> auth

username: XXX

password: XXX

> CREATE DATABASE traefik

> CREATE USER traefik WITH PASSWORD '<password>'

> GRANT ALL ON traefik to traefik

> SHOW GRANTS FOR traefik

database privilege

-------- ---------

traefik ALL PRIVILEGES

> quit

Dans mon cas, l’accès à InfluxDB se fait en https au travers d’une (autre) instance Traefik. J’utilise donc la connexion en http plutôt qu’en udp.

Cela donne les instructions suivantes en mode CLI :

--metrics=true

--metrics.influxdb=true

--metrics.influxdb.address=https://influxdb.domain.tld:443

--metrics.influxdb.protocol=http

--metrics.influxdb.database=traefik

--metrics.influxdb.username=traefik

--metrics.influxdb.password=<password>

J’ai gardé les valeurs par défaut pour addEntryPointsLabels (true), addServicesLabels (true) et pushInterval (10s).

Cela donne le Deployment suivant :

apiVersion: apps/v1

kind: Deployment

metadata:

name: traefik2-ingress-controller

labels:

k8s-app: traefik2-ingress-lb

spec:

replicas: 2

selector:

matchLabels:

k8s-app: traefik2-ingress-lb

template:

metadata:

labels:

k8s-app: traefik2-ingress-lb

name: traefik2-ingress-lb

spec:

serviceAccountName: traefik2-ingress-controller

terminationGracePeriodSeconds: 60

containers:

- image: traefik:2.0.6

name: traefik2-ingress-lb

ports:

- name: web

containerPort: 80

- name: admin

containerPort: 8080

- name: secure

containerPort: 443

readinessProbe:

httpGet:

path: /ping

port: admin

failureThreshold: 1

initialDelaySeconds: 10

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 2

livenessProbe:

httpGet:

path: /ping

port: admin

failureThreshold: 3

initialDelaySeconds: 10

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 2

args:

- --entryPoints.web.address=:80

- --entryPoints.secure.address=:443

- --entryPoints.traefik.address=:8080

- --api.dashboard=true

- --api.insecure=true

- --ping=true

- --providers.kubernetescrd

- --providers.kubernetesingress

- --log.level=ERROR

- --metrics=true

- --metrics.influxdb=true

- --metrics.influxdb.address=https://influxdb.domain.tld:443

- --metrics.influxdb.protocol=http

- --metrics.influxdb.database=traefik

- --metrics.influxdb.username=traefik

- --metrics.influxdb.password=<password>

Appliquer le contenu du fichier dans votre cluster Kubernetes

kubectl apply -f deployment.yml -n <namespace>

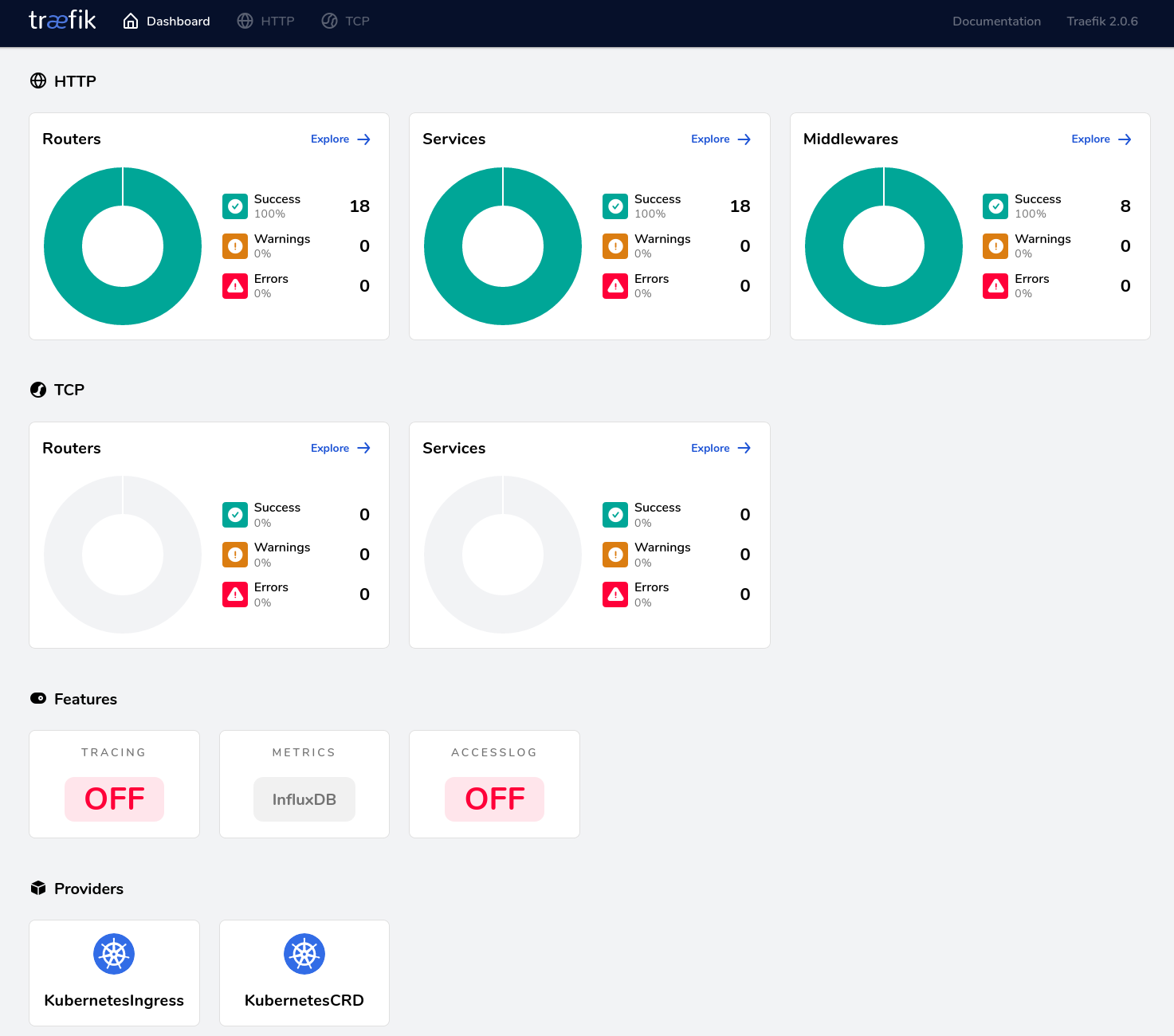

Sur le dashboard Traefik, dans la section “Features”, la boite “Metrics” doit afficher “InfluxDB”, comme ci-dessous :

Vous pouvez alors vous connecter à votre instance InfluxDB pour valider que des données sont bien insérées :

influx

Connected to http://localhost:8086 version 1.7.8

InfluxDB shell version: 1.7.9

> auth

username: traefik

password:

> use traefik

Using database traefik

> show measurements

name: measurements

name

----

traefik.config.reload.lastSuccessTimestamp

traefik.config.reload.total

traefik.entrypoint.connections.open

traefik.entrypoint.request.duration

traefik.entrypoint.requests.total

traefik.service.connections.open

traefik.service.request.duration

traefik.service.requests.total

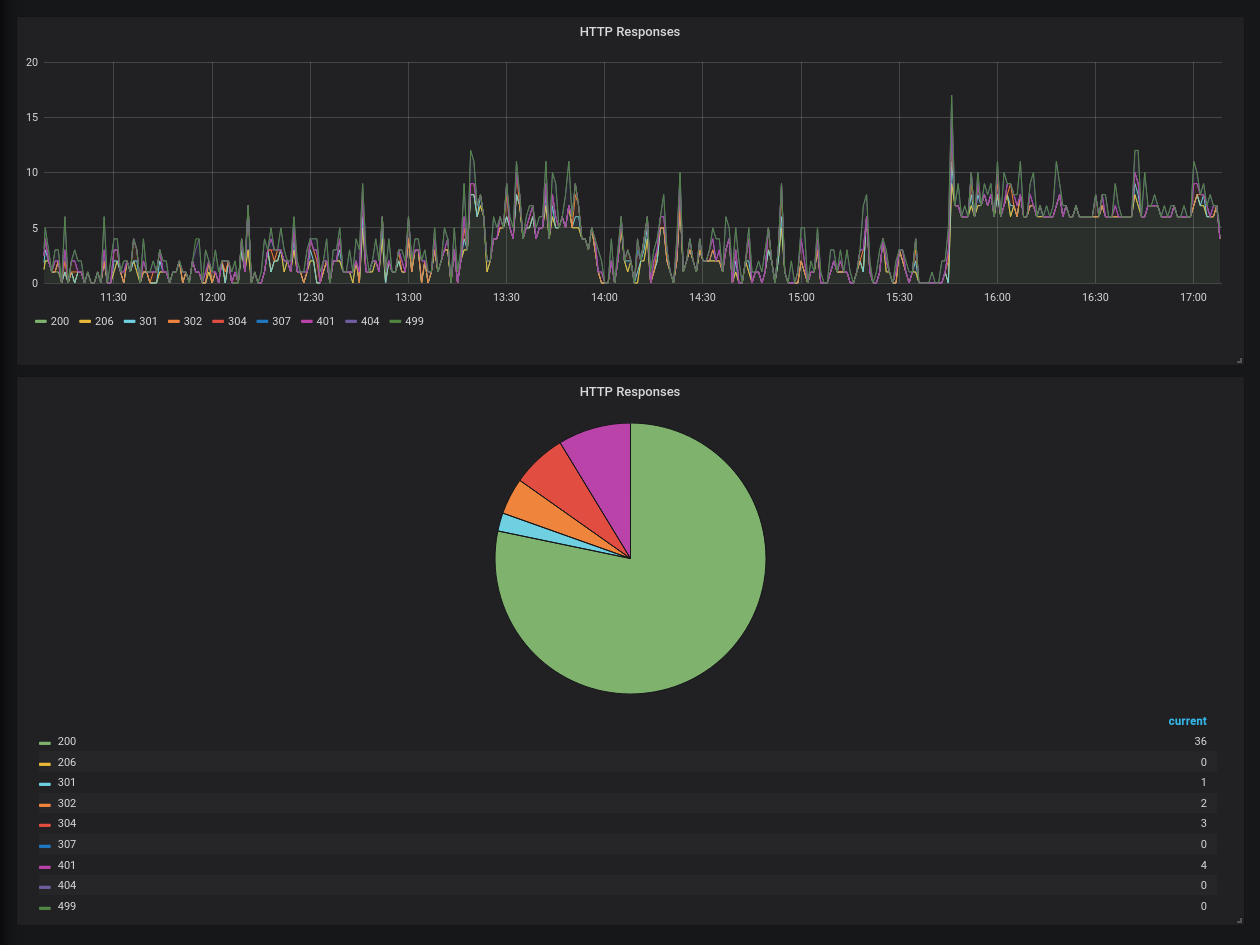

Il ne vous reste plus qu’à utiliser Chronograf ou Grafana pour visualiser vos données et définir des alertes.

Un exemple rapide avec la répartition des codes HTTP dans Grafana :